Comprender el lenguaje: la perspectiva humana frente a ChatGPT

¿Cuál es la diferencia entre la comprensión del lenguaje humana y la de ChatGPT? Preguntemos a la lingüística.

Ha pasado más de un año desde el lanzamiento de ChatGPT al mundo. Todavía hay mucho revuelo sobre si ChatGPT y sus versiones posteriores, incluido GPT-4, tienen una comprensión “verdadera” del lenguaje humano y si ahora estamos cerca de una Inteligencia Artificial General (Artificial General Intelligence, AGI) que sea tan inteligente como (o incluso más inteligente que) los humanos y posiblemente podrían esclavizar a la humanidad. En este artículo, exploraremos el tejido de lo que ChatGPT aprende sobre el lenguaje humano desde un punto de vista lingüístico, descubriendo las similitudes y grandes disparidades en nuestra comprensión humana, lo que, con suerte, ayudará a poner en perspectiva algunas de las afirmaciones hechas por los evangelistas de AGI y aliviará los temores de que la IA domine el mundo.

¿Cómo “aprende” ChatGPT el lenguaje humano?

Es sorprendentemente simple. Los modelos de lenguaje grandes (LLM) como ChatGPT se entrenan con una tarea llamada “predicción del próximo token”. Esto simplemente significa que al modelo se le presentan algunas palabras de una oración escrita por un humano (por ejemplo, tomada de Wikipedia) y se le pide que prediga la siguiente palabra. La predicción del modelo se compara con la palabra real que sigue a la oración. Si la predicción es incorrecta, el modelo (que es una red neuronal, es decir, muchas matrices apiladas unas sobre otras) se actualiza para que la próxima vez que vea la oración (o una similar), sea más probable se prediga el siguiente token real. Eso es todo, de verdad.

Fuente: Alammar, Jay. 2020. How GPT3 Works – Visualizations and Animations.

Ahora, lo siguiente sorprendente es que esto realmente funciona bastante bien, y descubrimos las “leyes de escalamiento”: cuanto más aumentas el tamaño de la red neuronal (más apilamiento de matrices) y cuantas más oraciones le das al modelo para entrenar, más capaz se volverá el modelo. Google Research ha realizado un buen análisis y visualización de las leyes de escala:

Fuente: Narang, S. y Chowdhery, A. 2022. Pathways Language Model (PaLM): Scaling to 540 Billion Parameters for Breakthrough Performance.

Descubrieron que un modelo con 8.000 millones de parámetros (8.000 millones de números en esas matrices apiladas) puede responder bastante bien algunas preguntas, pero no es bueno, por ejemplo, en traducción o resumen. Cuando el tamaño del modelo aumenta a 540.000 millones de parámetros (pero el concepto de arquitectura del modelo y el procedimiento de entrenamiento siguen siendo los mismos), surge en el modelo la capacidad de, por ejemplo, traducir y resumir texto. Sorprendentemente, no podemos explicar realmente por qué sucede esto, pero es algo que observamos y explotamos haciendo modelos cada vez más grandes.

Muy bien, así es como ChatGPT aprende el lenguaje. ¿Por qué sabe tanto?

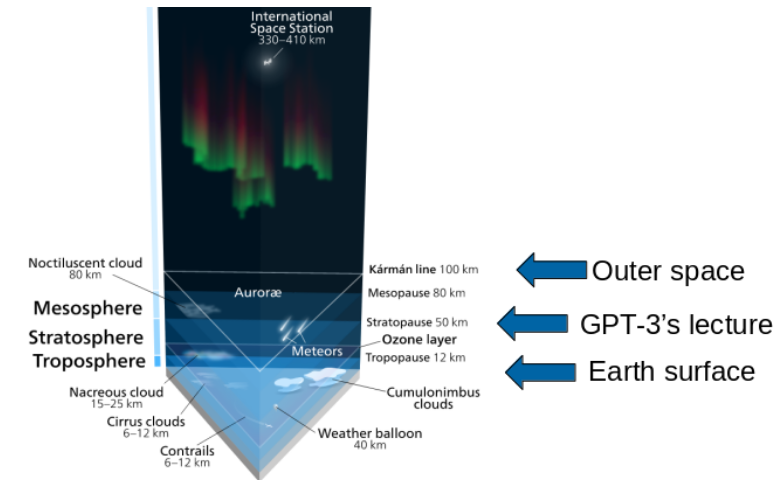

ChatGPT y sus hermanos han ingerido miles de millones de palabras durante su entrenamiento – mucho más que cualquier ser humano durante su educación. Para dar una idea de cuánto son 300.000 millones de “tokens” (la versión de palabras de ChatGPT) [1], el tamaño de los datos de entrenamiento de GPT 3, son: si imprimes 300.000 millones de fichas en papel A4 (500 palabras por página) y las apilas, obtienes una torre de aproximadamente 60 kilómetros de altura – ahí es donde comienza la estratosfera, o la altura de apilar más de 70 Burj Khalifa uno encima del otro.

Fuente: Wikipedia. Outer space.

Claramente, eso es mucho más de lo que cualquier ser humano ha leído – Podrías hacerlo en unos 5.700 años si lees 200 palabras por minuto durante 12 horas al día. Cuando se trata de leer el historial y el volumen, ChatGPT claramente tiene la ventaja.

Bien, ChatGPT ha ingerido muchos más textos de los que puedo leer. ¿Cuál es entonces la diferencia entre mi comprensión del lenguaje y la de ChatGPT?

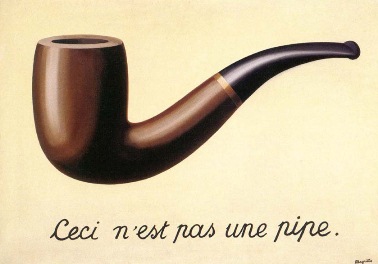

Sí, ¿ChatGPT no es simplemente más poderoso que tú por mucho que ha leído? Bueno, echemos un vistazo a cómo los humanos entendemos y representamos el significado de una palabra que hemos leído, digamos la palabra “pipa” (como en pipa para fumar). Hay una famosa pintura de la pintora Magritte:

Fuente: Wikipedia. The Treachery of Images.

La pintura tiene un texto escrito que dice “Esto no es una pipa”, mientras que claramente hay una pipa visible en la pintura. Pero espera… ¿realmente hay una tubería en el cuadro? Por supuesto que no, sólo hay una pintura de una pipa. Esta pintura divertida e ingeniosa demuestra una distinción intuitiva pero no siempre obvia de una manera sencilla: hay una diferencia entre las cosas a las que nos referimos y las cosas que usamos para referirnos a ellas. Trivialmente, una pintura de una pipa no es una pipa “real”, puede verse como un símbolo que hace referencia a una pipa (real o imaginaria).

Quizás ya nos preguntemos por qué hablamos de pinturas de pipas cuando intentamos profundizar en la diferencia entre nuestra comprensión del lenguaje y la de los grandes modelos de lenguaje. Tengamos paciencia, porque por esta puerta hemos entrado en el dominio de la semiótica, el estudio de los signos y símbolos. Podemos aplicar esta distinción entre las cosas del mundo real y los símbolos que usamos para referirlas al lenguaje y las palabras sin problemas: el lingüista suizo Ferdinand de Saussure presentó un modelo bien conocido que consiste en “el significado” (signifié; es decir, una pipa) y “el significante” (signifiant; es decir, la palabra pipa o la pintura de Magritte de una pipa).