Por qué la Inteligencia Artificial (IA) debe ser explicable

Los métodos de aprendizaje automático ya se están utilizando en muchas situaciones cotidianas. Ya sea en la conducción autónoma, donde se utiliza la inteligencia artificial (IA) para identificar peatones e intersecciones, o al desbloquear smartphones y portátiles modernos mediante el reconocimiento facial. Tan pronto como una IA toma decisiones sobre las personas, es fundamental que los procesos de toma de decisiones sean comprensibles tanto para los expertos como para los usuarios. Explicabilidad de la inteligencia artificial.

Si se utiliza una IA, en el contexto de la conducción autónoma, es fundamental para la aceptación y el uso de las tecnologías por parte de la población, que haya confianza en la correcta decisión de tales métodos. También se debe garantizar que el algoritmo en el que se basa una IA no haya aprendido ningún prejuicio inherente. Por ejemplo, en el curso de una decisión automatizada sobre la insolvencia de una persona, no debe existir discriminación por motivos de origen, sexo o similar. El Reglamento General de Protección de Datos (RGPD), que se aplica en todos los estados miembros de la Unión Europea desde 2018, también es objeto de un debate actual entre los expertos. En este contexto, se está discutiendo si el RGPD otorga a todos los ciudadanos el derecho a una explicación si una decisión que les afecta se tomó utilizando procesos automatizados como, por ejemplo, métodos de aprendizaje automático.

Hagamos que los procedimientos complejos sean transparentes

En el campo de investigación del aprendizaje automático, las llamadas redes neuronales han surgido como un método popular para resolver problemas de decisión en los últimos años. Por ejemplo, las redes neuronales pueden aprender de las imágenes qué objetos se representan en la imagen respectiva. Este tipo de problema de decisión se llama clasificación. Sin embargo, a diferencia de muchos métodos anteriores, es mucho más difícil – o casi imposible – que los procesos concretos de toma de decisiones de las redes neuronales se entiendan directamente debido a su complejidad. A diferencia de otros métodos de aprendizaje automático, que también pueden clasificar imágenes, las redes neuronales suelen lograr una mayor precisión en sus decisiones. En general, en el campo del aprendizaje automático, existe un compromiso entre métodos simples, a menudo insuficientemente precisos, y métodos complejos con un alto nivel de precisión.

Por lo tanto, la investigación actual sobre la explicabilidad de la inteligencia artificial a menudo se centra en hacer que el proceso de toma de decisiones de las redes neuronales complejas sea más transparente. Un enfoque de la explicabilidad es el intento de encontrar una ponderación adecuada para cada característica relevante para la decisión. Para una decisión individual, por ejemplo, si una persona es solvente, la edad de la persona, el gasto en el último año y las calificaciones crediticias anteriores pueden ser características decisivas. Una ponderación ata y positiva significa que la solvencia está positivamente relacionada con la característica. Si las características están en forma de imagen, dichos pesos se pueden representar como una imagen en la que a cada píxel se le asigna un peso. Los pesos altos a menudo se visualizan en un rojo distintivo, mientras que los pesos bajos se muestran en tonos de azul.

La alta precisión por sí sola no es suficiente

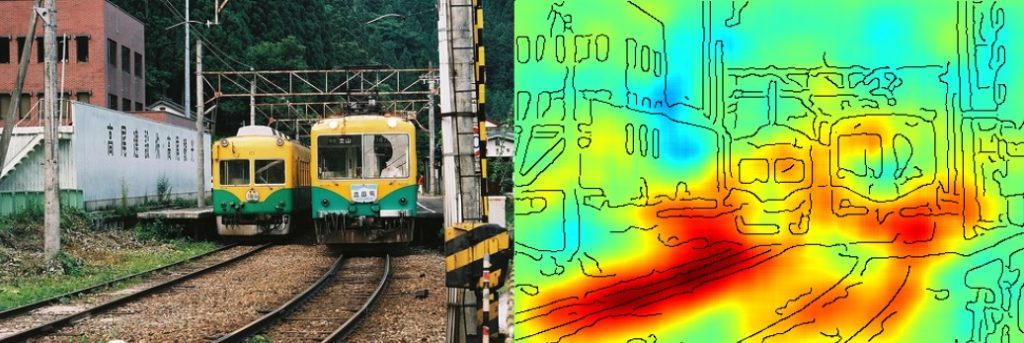

La siguiente figura muestra una visualización de los pesos de decisión. En una aplicación específica, un sistema debería usar procesos de aprendizaje automatizados para decidir si la foto presentada representa un tren. Los investigadores notaron por primera vez que la red neuronal podía distinguir con mucha precisión las imágenes con características de aquellas sin características. Sin embargo, al desglosar de manera transparente el proceso de toma de decisiones, se reveló que el algoritmo no había aprendido con éxito a identificar movimientos. En cambio, su decisión se basó principalmente en detectar raíles. Aunque el algoritmo logró un alto nivel de precisión en el reconocimiento de imágenes con trenes, tomó su decisión basándose en características incorrectas.

La red neuronal decidió que en esta imagen se mostraba un tren. Sin embargo, la percepción del proceso de toma de decisiones (figura derecha) muestra que el modelo solo ha aprendido a identificar raíles.

En la práctica, un modelo como el de arriba no debe usarse, porque no ha aprendido qué características componen un movimiento. Para las imágenes que muestran solo raíles y no trenes, el modelo decidiría erróneamente que un tren es visible. Este comportamiento es inaceptable para aplicaciones críticas para la seguridad, como la conducción autónoma. Imagine el caso en el que se utiliza una red neuronal de este tipo para detectar peatones. Si el modelo identificara incorrectamente a un peatón basándose en el pavimento de una acera, es posible que el mismo peatón no sea reconocido en un carril bici de diferente color. La detección de tales errores antes de que la red neuronal se utilice en la práctica es esencial, especialmente para aplicaciones críticas para la seguridad.

Las redes neuronales se han vuelto indispensables en el panorama actual de investigación del aprendizaje automático debido a su alto nivel de precisión. Sin embargo, en este momento, todavía no son adecuados para su uso en áreas críticas para la seguridad. La certificación necesaria de las redes neuronales para su uso en áreas críticas para la seguridad es difícil, porque rápidamente se vuelven demasiado complejas. Sin embargo, ya existen los primeros enfoques que hacen más transparentes los procesos de toma de decisiones. Un método para hacer que el proceso de toma de decisiones sea más transparente usando representaciones pictóricas es proporcionado por la visualización anterior usando una ponderación. Mediante este método ya es posible comprobar si la red neuronal ha interiorizado conceptos concretos (como las características visuales de un tren) o si utiliza erróneamente otras características para la decisión, que a menudo aparecen juntas (como los raíles en el ejemplo anterior). El desarrollo adicional de estos enfoques para decodificar decisiones de procesos de aprendizaje complejos es, por lo tanto, un objetivo central de investigación para hacer que las ventajas de las redes neuronales sean utilizables por el público en general.

Explicabilidad de la inteligencia artificial

Hay mucha más información sobre el tema de la explicabilidad de la inteligencia artificial para leer, incluso en el libro: ‘Interpretable Machine Learning – A Guide for Making Black Box Models Explainable”.

Fuente: